Yorumlanabilirliğin Aciliyeti: Yapay Zeka ve İnsan Etkileşimi

Yorumlanabilirlik Nedir?

Yorumlanabilirlik, bir sistemin veya modelin karar verme sürecinin anlaşılabilirliği ve şeffaflığı ile ilgili bir kavramdır. Özellikle yapay zeka (YZ) sistemlerinin giderek daha fazla kullanılmaya başlandığı bir dönemde, bu kavramın önemi daha da artmaktadır. Yorumlanabilir, kullanıcıların ve geliştiricilerin sistemin nasıl çalıştığını ve sonuçlarına nasıl ulaştığını anlamasını sağlar. Aynı zamanda etik ve güvenilirlik açısından da kritik bir rol oynamaktadır.

Yorumlanabilirliğin tarihi, aslında veri bilimi ve istatistik bilimine kadar uzanır. İlkçağlardan beri insanlar, olayların nedenlerini anlamak için analiz yapma ihtiyacı duymuşlardır. Ancak modern yapay zeka sistemlerinin karmaşıklığı göz önüne alındığında, yorumlanabilirlik, sadece basit bir analiz olmaktan çıkmış, derin öğrenme gibi karmaşık yapay zeka teknikleri için ciddi bir zorluk haline gelmiştir. Günümüzde birçok YZ uygulaması ‘kara kutu’ olarak adlandırılan bir işleyişe sahiptir. Bu, kullanıcıların sonuçları yorumlaması gereken süreçlerin oldukça belirsiz olduğu anlamına gelir.

Yorumlanabilirlik, hem araştırma hem de pratik uygulama aşamalarında kritik bir öneme sahip. Örneğin, sağlık alanında kullanılan bir yapay zeka sisteminin kararlarını ve önerilerini yorumlayabilmek, hastalar üzerinde olumsuz etkilerin önüne geçmekte önemli bir yere sahiptir. Aynı zamanda finansal alanlarda, yatırım kararlarının açıklanabilirliği, yatırımcılar açısından güvenin inşa edilmesini sağlar. Bu gibi örnekler, yorumlanabilirliğin arttırılmasının sadece teknik bir gereklilik değil, aynı zamanda sosyal ve etik bir sorumluluk olduğunu ortaya koymaktadır.

Yapay Zeka ve Şeffaflık Problemi

Yapay zeka (YZ) sistemlerinin birçoğu, karar verme süreçlerinde şeffaflık eksikliği sebebiyle önemli sorunlarla karşı karşıyadır. Şeffaflık, bir algılama süreci veya karar mekanizmasının nasıl işlediğini anlama fırsatı sunar. Ancak makine öğrenimi algoritmalarının karmaşıklığı ve soyutluğu, bu süreçlerin anlaşılmasını oldukça güçleştirmektedir. Kullanıcıların YZ ile etkileşimi sırasında karşılaştığı en büyük zorluklardan biri, algoritmanın nasıl çalıştığı ve hangi verileri kullandığına dair belirsizliktir. Bu durum, kullanıcıların YZ sistemine olan güvenini zedeleyebilir ve yanlış anlamalara yol açabilir.

Ayrıca, şeffaflığın yetersizliği, toplumsal eşitlik ve adalet konularında da sorunlar yaratmaktadır. YZ sistemlerinin aldığı kararların arkasındaki mantık ve verilerin gizli kalması, ayrımcı uygulamalara ve etik ihlallere zemin hazırlayabilir. Özellikle, finansal, sağlık ve eğitim gibi kritik alanlarda, YZ’nin verdiği kararların anlaşılabilir olmaması, mağduriyetlere yol açabilir. Kullanıcılar, kararların nasıl alındığını kavrayamadığı takdirde, bu süreçlerin adil olup olmadığını da sorgulamakta zorluk çekerler.

Şeffaflık problemini ele almak adına çeşitli çözümler geliştirilmiştir. Bu çözümler arasında, açıklanabilir yapay zeka (XAI) uygulamaları öne çıkmaktadır. XAI, kullanıcıların YZ sistemlerinin karar alma süreçlerini daha iyi anlamasını sağlamayı hedefler. Bunun yanı sıra, veri gizliliği ile şeffaflık arasında bir denge kurmaya yönelik çabalar, YZ sistemlerinin güvenilirliğini artırmak için önem taşır. Ancak, bu çözümlerin etkinliği yetersiz kalabiliyor ve daha kapsamlı stratejilere ihtiyaç duyulmaktadır. Yapay zeka sistemlerinde şeffaflığın sağlanması, hem kullanıcılar hem de toplum için kritik öneme sahiptir ve bu alandaki çalışmalar devam etmektedir.

Yorumlanabilirliğin İyileştirilmesi İçin Yöntemler

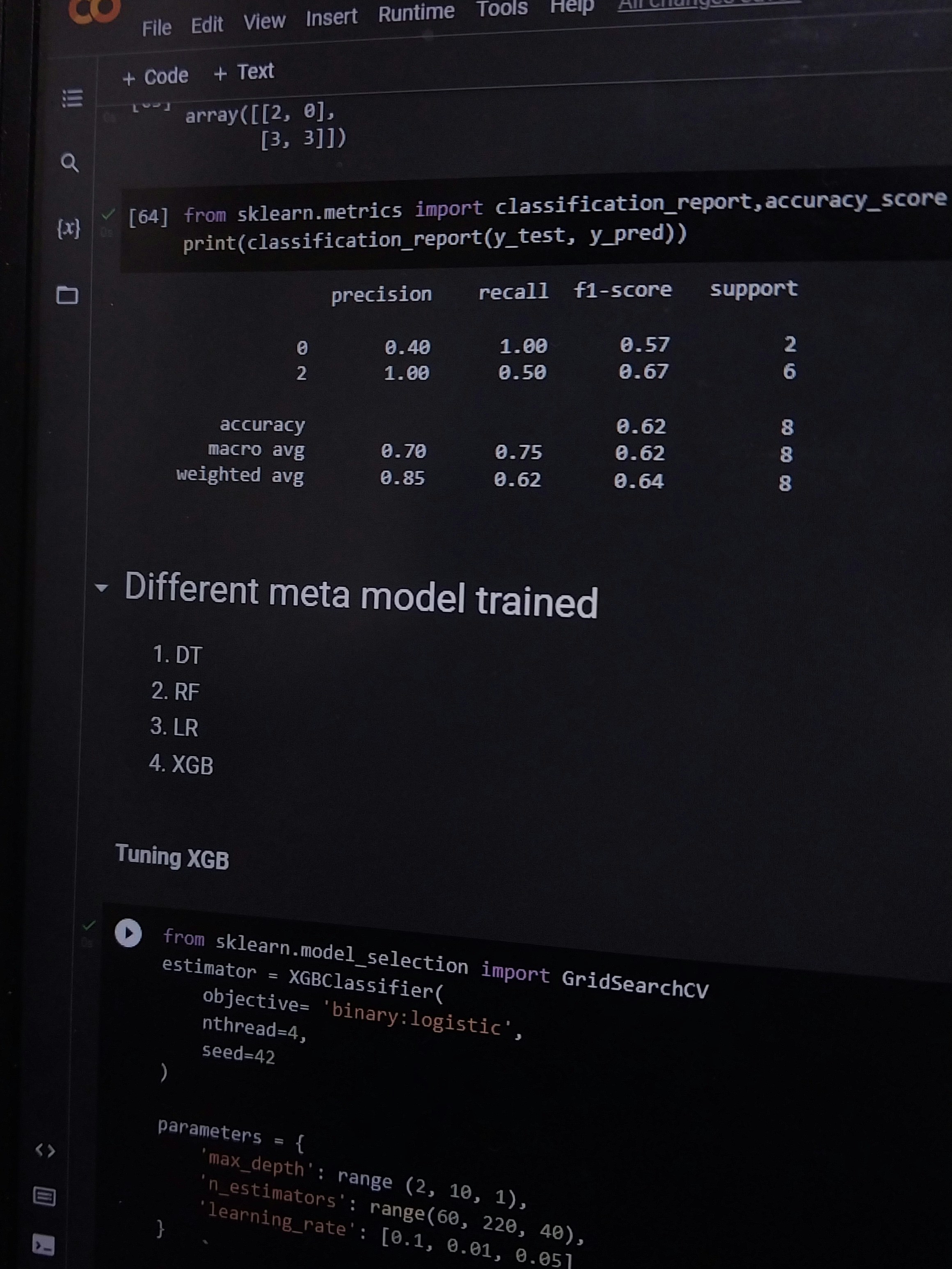

Yapay zeka sistemlerinde yorumlanabilirliği artırmak, kullanıcıların ve geliştiricilerin sistemlerin nasıl çalıştığını daha iyi anlamalarına yardımcı olacaktır. Bu nedenle, çeşitli yöntemlerin ve tekniklerin geliştirilmesi büyük bir önem taşımaktadır. İlk olarak, model açıklayıcılığı sağlayan araçlar, kullanıcıların algoritmaların karar süreçlerini daha iyi anlamalarına olanak tanır. Örneğin, LIME (Local Interpretable Model-agnostic Explanations) ve SHAP (SHapley Additive exPlanations) gibi araçlar, belirli çıkışların hangi girdilerle bağlantılı olduğunu açıklamak için kullanılır. Bu tür araçlar, kullanıcıların yapay zeka sistemlerinin sonuçlarını yorumlamalarına yardımcı olmaktadır.

Bir diğer önemli yöntem ise görselleştirme tekniklerinin uygulanmasıdır. Veri kümesine dair grafik ve diagramlar, karmaşık bilgilerin daha anlaşılır bir şekilde sunulmasını sağlar. Görselleştirme, kullanıcıların sistemlerin iç işleyişini daha iyi kavramalarına ve karar alma süreçlerini net bir şekilde görmelerine yardımcı olur. Örneğin, modelin öğrenme sürecini gösteren görseller, kullanıcılara hangi öğelerin nasıl etki ettiğini açıkça gösterir.

Ayrıca, kullanıcı geri bildirimlerinin entegrasyonu, yapay zeka sistemlerinin yorumlanabilirliğini artıran bir diğer önemli unsurdur. Kullanıcıların deneyimleri ve verdikleri geri bildirimler, sistemlerin geliştirilmesinde önemli bir rol oynar. Bu sayede, yapay zeka sistemlerinin kullanıcı dostu hale gelmesi ve doğru kararlar vermesi sağlanabilir. Tüm bu yöntemlerin uygulanması, yapay zeka sistemlerinde yorumlanabilirliğin artmasına katkıda bulunarak, kullanıcı kararlılığı ve güvenini artırır. Başarılı uygulama örnekleri bu yaklaşımların etkisini daha da pekiştirmektedir.

Gelecek Perspektifi: Yorumlanabilirlik ve Etik

Yapay zeka (YZ) teknolojisinin hızla geliştiği günümüzde, yorumlanabilirlik ve etik sorular, bu alandaki en önemli konular arasında yer almaktadır. Yorumlanabilirlik, bir YZ modelinin karar alma süreçlerini şeffaf bir şekilde anlamayı ifade ederken, etik ise bu teknolojilerin yaratabileceği sosyal etkileri, bireylerin haklarını ve veri gizliliği gibi meseleleri kapsamaktadır. Gelecekte, yapay zeka uygulamalarının hem bireyler hem de toplum üzerindeki etkilerini değerlendirmek için yorumlanabilirliğin kritik bir rol oynayacağı öngörülmektedir.

Yorumlanabilirlik, kullanıcıların YZ sistemleri ile daha güvenilir bir etkileşim kurmasına olanak tanır. Kullanıcılar, YZ’nin nasıl çalıştığını ve kararlarının arkasındaki mantığı anlayarak, bu sistemlerin sunduğu sonuçlara daha fazla güven duyar. Etik bağlamda ise, yapay zeka sistemlerinin insan haklarına, gizlilik haklarına ve adalet anlayışına uygun biçimde tasarlanması gereklidir. Özellikle otoritelerin veriyi nasıl topladığı ve kullandığı konusunda şeffaflık sağlanması gerekliliği, toplumsal kabul için elzemdir.

Ayrıca, gelecekteki YZ araştırmacılarının ve geliştiricilerinin etik standartlar oluşturması ve bunlara uyması kritik önem taşımaktadır. Bu bağlamda, disiplinler arası işbirliği ve paydaşların katılımı ile toplumun ihtiyaçlarını dikkate alan yaklaşımlar geliştirilmelidir. Eğitim programlarının YZ uygulamalarının etik yönlerine odaklanması, gelecek nesil geliştiricilerin bu konuları önemsemesini sağlayabilir. Dunyanın giderek daha çok YZ’ye bağımlı hale geldiği göz önüne alındığında, yorumlanabilirlik ve etik konularının önemi daha da artmaktadır.

Share this content:

Yorum gönder